現在我們要開始填充函數了。

def create_dataset(hm,variance,step=2,correlation=False):

val = 1

ys = []

for i in range(hm):

y = val + random.randrange(-variance,variance)

ys.append(y)

非常簡單,我們僅僅使用hm變量,迭代我們所選的范圍,將當前值加上一個負差值到證差值的隨機范圍。這會產生數據,但是如果我們想要的話,它沒有相關性。讓我們這樣:

def create_dataset(hm,variance,step=2,correlation=False):

val = 1

ys = []

for i in range(hm):

y = val + random.randrange(-variance,variance)

ys.append(y)

if correlation and correlation == 'pos':

val+=step

elif correlation and correlation == 'neg':

val-=step

非常棒了,現在我們定義好了 y 值。下面,讓我們創建 x,它更簡單,只是返回所有東西。

def create_dataset(hm,variance,step=2,correlation=False):

val = 1

ys = []

for i in range(hm):

y = val + random.randrange(-variance,variance)

ys.append(y)

if correlation and correlation == 'pos':

val+=step

elif correlation and correlation == 'neg':

val-=step

xs = [i for i in range(len(ys))]

return np.array(xs, dtype=np.float64),np.array(ys,dtype=np.float64)

我們準備好了。為了創建樣例數據集,我們所需的就是:

xs, ys = create_dataset(40,40,2,correlation='pos')

讓我們將之前線性回歸教程的代碼放到一起:

from statistics import mean

import numpy as np

import random

import matplotlib.pyplot as plt

from matplotlib import style

style.use('ggplot')

def create_dataset(hm,variance,step=2,correlation=False):

val = 1

ys = []

for i in range(hm):

y = val + random.randrange(-variance,variance)

ys.append(y)

if correlation and correlation == 'pos':

val+=step

elif correlation and correlation == 'neg':

val-=step

xs = [i for i in range(len(ys))]

return np.array(xs, dtype=np.float64),np.array(ys,dtype=np.float64)

def best_fit_slope_and_intercept(xs,ys):

m = (((mean(xs)*mean(ys)) - mean(xs*ys)) /

((mean(xs)*mean(xs)) - mean(xs*xs)))

b = mean(ys) - m*mean(xs)

return m, b

def coefficient_of_determination(ys_orig,ys_line):

y_mean_line = [mean(ys_orig) for y in ys_orig]

squared_error_regr = sum((ys_line - ys_orig) * (ys_line - ys_orig))

squared_error_y_mean = sum((y_mean_line - ys_orig) * (y_mean_line - ys_orig))

print(squared_error_regr)

print(squared_error_y_mean)

r_squared = 1 - (squared_error_regr/squared_error_y_mean)

return r_squared

xs, ys = create_dataset(40,40,2,correlation='pos')

m, b = best_fit_slope_and_intercept(xs,ys)

regression_line = [(m*x)+b for x in xs]

r_squared = coefficient_of_determination(ys,regression_line)

print(r_squared)

plt.scatter(xs,ys,color='#003F72', label = 'data')

plt.plot(xs, regression_line, label = 'regression line')

plt.legend(loc=4)

plt.show()

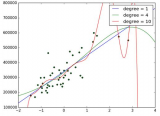

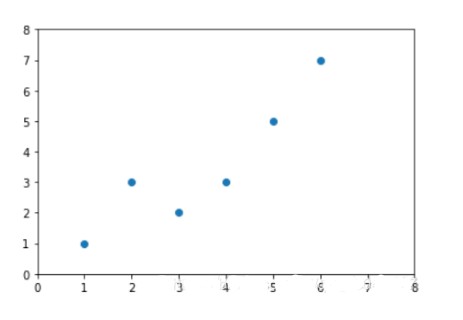

執行代碼,你會看到:

?

判定系數是 0.516508576011(要注意你的結果不會相同,因為我們使用了隨機數范圍)。

不錯,所以我們的假設是,如果我們生成一個更加緊密相關的數據集,我們的 R 平方或判定系數應該更好。如何實現它呢?很簡單,把范圍調低。

xs, ys = create_dataset(40,10,2,correlation='pos')

?

?

現在我們的 R 平方值為 0.939865240568,非常不錯,就像預期一樣。讓我們測試負相關:

xs, ys = create_dataset(40,10,2,correlation='neg')

?

R 平方值是 0.930242442156,跟之前一樣好,由于它們參數相同,只是方向不同。

這里,我們的假設證實了:變化越小 R 值和判定系數越高,變化越大 R 值越低。如果是不相關呢?應該很低,接近于 0,除非我們的隨機數排列實際上有相關性。讓我們測試:

xs, ys = create_dataset(40,10,2,correlation=False)

?

判定系數為 0.0152650900427。

現在為止,我覺得我們應該感到自信,因為事情都符合我們的預期。

既然我們已經對簡單的線性回歸很熟悉了,下個教程中我們開始講解分類。

電子發燒友App

電子發燒友App

評論