在開始編程之前,先讓我們準備一份基本的路線圖。我們的目標是創建一個特定架構(層數、層大小、激活函數)的密集連接神經網絡。然后訓練這一神經網絡并做出預測。

2018-10-18 09:02:43 3187

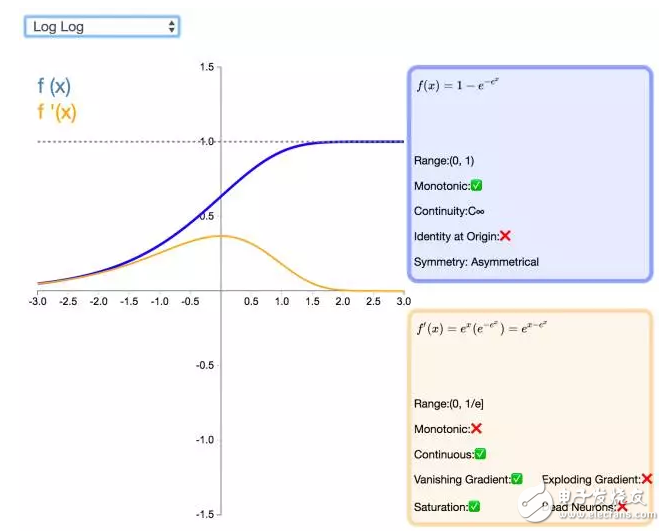

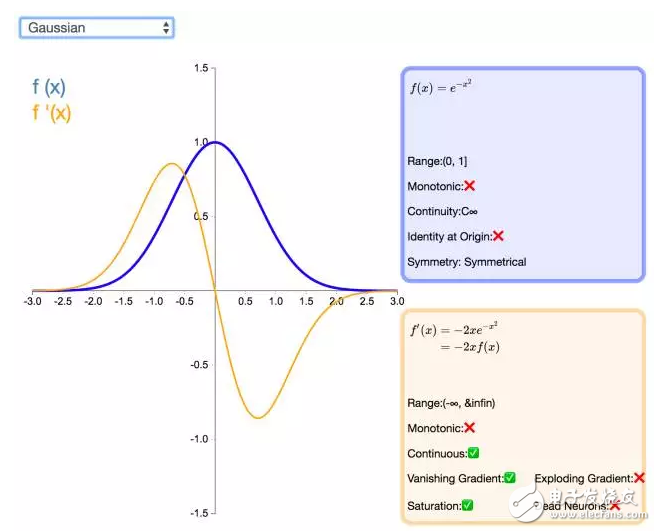

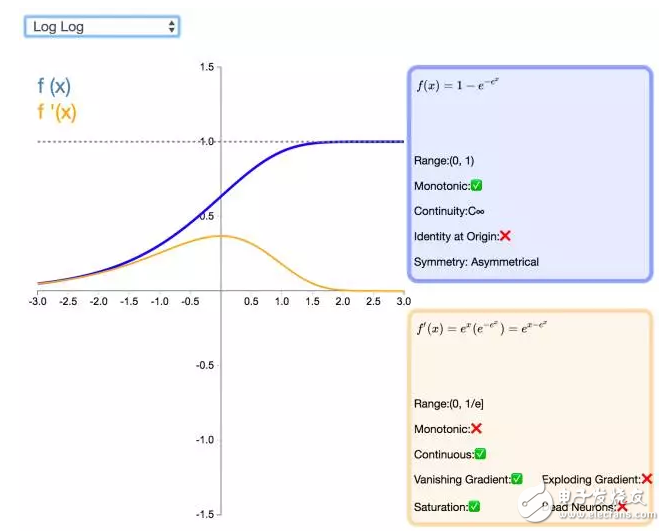

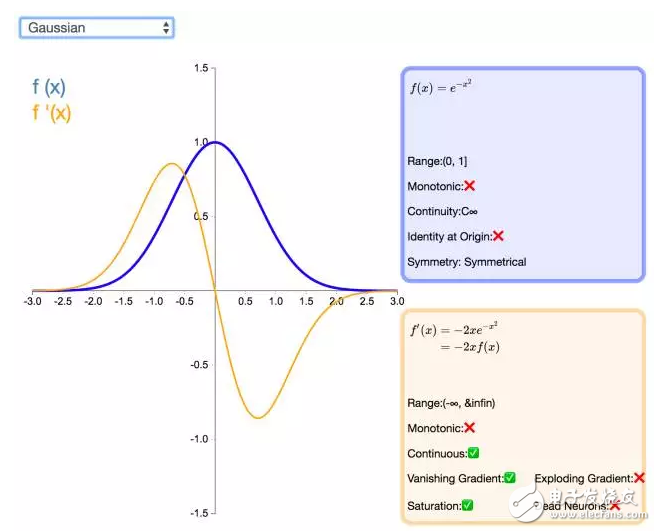

3187 在兩層神經網絡之間,必須有激活函數連接,從而加入非線性因素,提高神經網絡的能力。所以,我們先從激活函數學起,一類是擠壓型的激活函數,常用于簡單網絡的學習;另一類是半線性的激活函數,常用于深度網絡的學習。

2023-08-07 10:02:29 441

441

神經網絡Matlab程序

2009-09-15 12:52:24

神經網絡基本介紹

2018-01-04 13:41:23

第1章 概述 1.1 人工神經網絡研究與發展 1.2 生物神經元 1.3 人工神經網絡的構成 第2章人工神經網絡基本模型 2.1 MP模型 2.2 感知器模型 2.3 自適應線性

2012-03-20 11:32:43

將神經網絡移植到STM32最近在做的一個項目需要用到網絡進行擬合,并且將擬合得到的結果用作控制,就在想能不能直接在單片機上做神經網絡計算,這樣就可以實時計算,不依賴于上位機。所以要解決的主要是兩個

2022-01-11 06:20:53

神經網絡簡介

2012-08-05 21:01:08

基于深度學習的神經網絡算法

2019-05-16 17:25:05

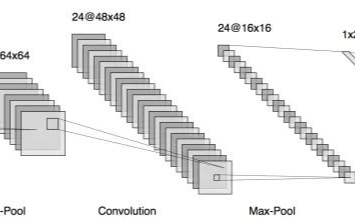

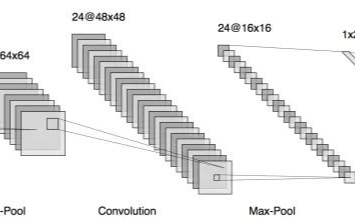

,不斷地進行學習訓練,一直到網絡輸出的誤差減少到可以接受的程度。 B、卷積神經網絡卷積神經網絡是一種前饋神經網絡,它的人工神經元可以響應一部分覆蓋范圍內的周圍單元。換個角度思考,卷積神經網絡就是多層

2018-06-05 10:11:50

解模型結構、激活函數、模型參數形狀(神經元數量)等keras 中有一些現成的包可以創建我們的神經網絡模型的可視化表示。前三個包可以在模型訓練之前使用(只需要定義和編譯模型);但是Tensor

2022-11-02 14:55:04

MATLAB神經網絡

2013-07-08 15:17:13

遞歸網絡newelm 創建一Elman遞歸網絡2. 網絡應用函數sim 仿真一個神經網絡init 初始化一個神經網絡adapt 神經網絡的自適應化train 訓練一個神經網絡3. 權函數dotprod

2009-09-22 16:10:08

TF:TF之Tensorboard實踐:將神經網絡Tensorboard形式得到eventsouttfevents文件+dos內運行該文件本地服務器輸出到網頁可視化

2018-12-21 10:43:41

TensorFlow 使用 TensorBoard 來提供計算圖形的圖形圖像。這使得理解、調試和優化復雜的神經網絡程序變得很方便。TensorBoard 也可以提供有關網絡執行的量化指標。它讀取

2020-07-22 21:26:55

請問:我在用labview做BP神經網絡實現故障診斷,在NI官網找到了機器學習工具包(MLT),但是里面沒有關于這部分VI的幫助文檔,對于”BP神經網絡分類“這個范例有很多不懂的地方,比如

2017-02-22 16:08:08

習神經神經網絡,對于神經網絡的實現是如何一直沒有具體實現一下:現看到一個簡單的神經網絡模型用于訓練的輸入數據:對應的輸出數據:我們這里設置:1:節點個數設置:輸入層、隱層、輸出層的節點

2021-08-18 07:25:21

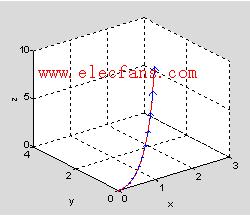

TF之NN:matplotlib動態演示深度學習之tensorflow將神經網絡系統自動學習散點(二次函數+noise)并優化修正并且將輸出結果可視化

2018-12-21 10:48:26

盤點與展望

正文

神經網絡的結構

典型的經典神經網絡的結構:CNN(卷積神經網絡),CNN以陣列的方式輸入數據,經過多層網絡的卷積、鏈接、激活等過程,最終輸出結果,是一種經典的結構,但存在以下

2023-09-16 11:11:01

的卷積進行升維和降維(如圖4),還可以調整直連的位置來對其做出調整,介紹圖形結合,比較利于理解。對于初端塊,舉例了不同初端塊結構(如圖5),了解到神經網絡中的\"跳躍連接塊\"

2023-09-11 20:34:01

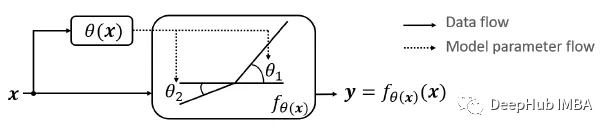

`本篇主要介紹:人工神經網絡的起源、簡單神經網絡模型、更多神經網絡模型、機器學習的步驟:訓練與預測、訓練的兩階段:正向推演與反向傳播、以TensorFlow + Excel表達訓練流程以及AI普及化教育之路。`

2020-11-05 17:48:39

,得到訓練參數2、利用開發板arm與FPGA聯合的特性,在arm端實現圖像預處理已經卷積核神經網絡的池化、激活函數和全連接,在FPGA端實現卷積運算3、對整個系統進行調試。4、在基本實現系統的基礎上

2018-12-19 11:37:22

學習和認知科學領域,是一種模仿生物神經網絡(動物的中樞神經系統,特別是大腦)的結構和功能的數學模型或計算模型,用于對函數進行估計或近似。神經網絡由大量的人工神經元聯結進行計算。大多數情況下人工神經網絡

2019-03-03 22:10:19

。可以看到文件列表中多了一個我們剛剛克隆的項目。如下圖: 圖3神經網絡源碼分析在運行代碼之前,我們先來了解一下神經網絡代碼的構成。代碼至少包含三個函數。初始化函數--設定輸入層節點、隱藏層 節點和輸出層

2019-03-18 21:51:33

是一種常用的無監督學習策略,在使用改策略時,網絡的輸出神經元相互競爭,每一時刻只有一個競爭獲勝的神經元激活。ART神經網絡由比較層、識別層、識別閾值、重置模塊構成。其中比較層負責接收輸入樣本,并將其傳遞

2019-07-21 04:30:00

傳播的,不會回流),區別于循環神經網絡RNN。BP算法(Back Propagation):誤差反向傳播算法,用于更新網絡中的權重。BP神經網絡思想:表面上:1. 數據信息的前向傳播,從輸入層到隱含層

2019-07-21 04:00:00

可視化過程如下圖所示(圖來源于網絡):

為什么要引入激活層?

以下回答引用自參考6:

引入激活函數是為了增加神經網絡的非線性,如果不用激活函數,每一層都是上一層的線性輸入,這樣一來,無論神經網絡有

2023-08-18 06:56:34

人工神經網絡是根據人的認識過程而開發出的一種算法。假如我們現在只有一些輸入和相應的輸出,而對如何由輸入得到輸出的機理并不清楚,那么我們可以把輸入與輸出之間的未知過程看成是一個“網絡”,通過不斷地給

2008-06-19 14:40:42

人工神經網絡(Artificial Neural Network,ANN)是一種類似生物神經網絡的信息處理結構,它的提出是為了解決一些非線性,非平穩,復雜的實際問題。那有哪些辦法能實現人工神經網絡呢?

2019-08-01 08:06:21

人工神經網絡課件

2016-06-19 10:15:48

簡單理解LSTM神經網絡

2021-01-28 07:16:57

圖卷積神經網絡

2019-08-20 12:05:29

思維導圖如下:發展歷程DNN-定義和概念在卷積神經網絡中,卷積操作和池化操作有機的堆疊在一起,一起組成了CNN的主干。同樣是受到獼猴視網膜與視覺皮層之間多層網絡的啟發,深度神經網絡架構架構應運而生,且

2018-05-08 15:57:47

全連接神經網絡和卷積神經網絡的區別

2019-06-06 14:21:42

Keras實現卷積神經網絡(CNN)可視化

2019-07-12 11:01:52

以前的神經網絡幾乎都是部署在云端(服務器上),設備端采集到數據通過網絡發送給服務器做inference(推理),結果再通過網絡返回給設備端。如今越來越多的神經網絡部署在嵌入式設備端上,即

2021-12-23 06:16:40

卷積神經網絡為什么適合圖像處理?

2022-09-08 10:23:10

卷積神經網絡(CNN)究竟是什么,鑒于神經網絡在工程上經歷了曲折的歷史,您為什么還會在意它呢? 對于這些非常中肯的問題,我們似乎可以給出相對簡明的答案。

2019-07-17 07:21:50

為 三個過程:輸入信號線性加權、求和、非線性激活。1958 年到 1969 年為神經網絡模型發展的第一階段, 稱為第一代神經網絡模型。在 1958 年 Rosenblatt 第 一次在 MCP 模型上

2022-08-02 10:39:39

卷積神經網絡的層級結構 卷積神經網絡的常用框架

2020-12-29 06:16:44

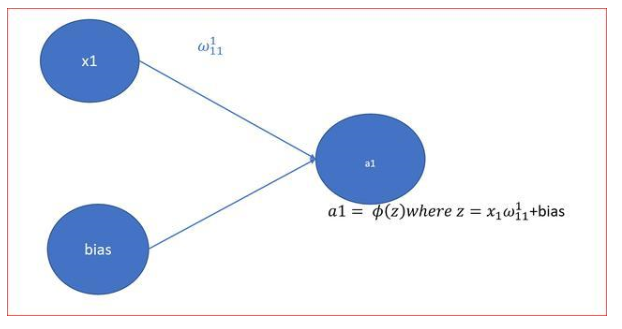

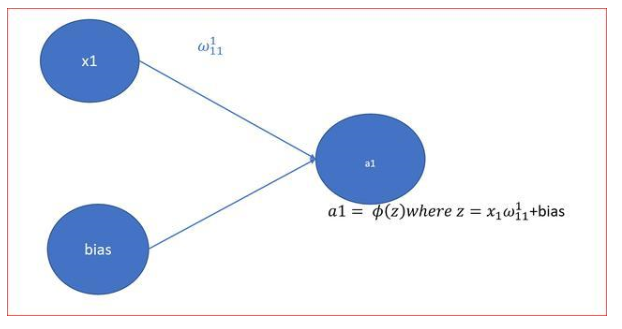

可以用數學來描述為其中 f = 激活函數,w = 權重,x = 輸入數據,b = 偏差。數據可以作為單個標量、向量或矩陣形式出現。圖1顯示了一個具有三個輸入和一個ReLU的神經元^2^激活功能。網絡中

2023-02-23 20:11:10

什么是卷積神經網絡?ImageNet-2010網絡結構是如何構成的?有哪些基本參數?

2021-06-17 11:48:22

最近在學習電機的智能控制,上周學習了基于單神經元的PID控制,這周研究基于BP神經網絡的PID控制。神經網絡具有任意非線性表達能力,可以通過對系統性能的學習來實現具有最佳組合的PID控制。利用BP

2021-09-07 07:43:47

FPGA實現神經網絡關鍵問題分析基于FPGA的ANN實現方法基于FPGA的神經網絡的性能評估及局限性

2021-04-30 06:58:13

如何使用STM32F4+MPU9150去實現一種神經網絡識別手勢呢?其過程是怎樣的?

2021-11-19 06:38:58

如何用stm32cube.ai簡化人工神經網絡映射?如何使用stm32cube.ai部署神經網絡?

2021-10-11 08:05:42

AD中非可視化區域物件怎么移到可視化區域???

2019-09-10 05:36:41

原文鏈接:http://tecdat.cn/?p=5725 神經網絡是一種基于現有數據創建預測的計算系統。如何構建神經網絡?神經網絡包括:輸入層:根據現有數據獲取輸入的層隱藏層:使用反向傳播優化輸入變量權重的層,以提高模型的預測能力輸出層:基于輸入和隱藏層的數據輸出預測

2021-07-12 08:02:11

訓練一個神經網絡并移植到Lattice FPGA上,通常需要開發人員既要懂軟件又要懂數字電路設計,是個不容易的事。好在FPGA廠商為我們提供了許多工具和IP,我們可以在這些工具和IP的基礎上做

2020-11-26 07:46:03

神經網絡(Neural Networks)是人工神經網絡(Ar-tificial Neural Networks)的簡稱,是當前的研究熱點之一。人腦在接受視覺感官傳來的大量圖像信息后,能迅速做出反應

2019-08-08 06:11:30

能力是無法解決的。而量子神經網絡被認為是一種具有固有模糊性的網絡,它的隱層單元采用多量子能級變換函數,每個多能級變換函數是一系列具有量子間隔偏移的S型函數之和,能將決策的不確定性數據合理地分配到各類故障

2019-07-05 08:06:02

概述:ZISC78是由IBM和Sillicon聯合研發的一種具有自學習功能的徑向基函數神經網絡芯片,它內含78個神經元;并且采用并行結構,運行速度與神經元數量無關;支持RBF/KNN算法;內部可分為若干獨立子網...

2021-04-07 06:48:33

本文提出了一個基于FPGA 的信息處理的實例:一個簡單的人工神經網絡應用Verilog 語言描述,該數據流采用模塊化的程序設計,并考慮了模塊間數據傳輸信號同 步的問題,有效地解決了人工神經網絡并行數據處理的問題。

2021-05-06 07:22:07

數字化可視化的Web組態軟件有哪些?都有何優缺點?

2021-09-26 08:19:39

求助地震波神經網絡程序,共同交流!!

2013-05-11 08:14:19

小女子做基于labview的蒸發過程中液位的控制,想使用神經網絡pid控制,請問這個控制方法可以嗎?有誰會神經網絡pid控制么。。。叩謝

2016-09-23 13:43:16

求助大神 小的現在有個難題: 一組車重實時數據 對應一個車重的最終數值(一個一維數組輸入對應輸出一個數值) 這其中可能經過均值、方差、去掉N個最大值、、、等等的計算 我的目的就是弄清楚這個中間計算過程 最近實在想不出什么好辦法就打算試試神經網絡 請教大神用什么神經網絡好求神經網絡程序

2016-07-14 13:35:44

一些可視化的手段以理解深度卷積神經網絡。直接可視化第一層濾波器由于第一層卷積層的濾波器直接在輸入圖像中滑動,我們可以直接對第一層濾波器進行可視化。可以看出,第一層權重關注于特定朝向的邊緣以及特定色彩組合

2019-07-21 13:00:00

深度學習中的類別激活熱圖可視化

2021-02-03 07:02:53

最簡單的神經網絡

2019-09-11 11:57:36

一種基于嵌入式Linux的可視化安全倒車系統設計

2021-05-12 06:39:42

通過excel構筑字模可視化的教程分享

2022-01-21 06:14:56

人工神經網絡具有高計算能力、泛化能力和非線性映射等特點,被成功應用于眾多領域,但缺乏用于確定其網絡拓撲結構、激活函數和訓練方法的規則。該文提出利用遺傳算法優化

2009-04-13 08:42:32 18

18 提出一種前饋神經網絡盲多用戶檢測算法,利用前饋神經網絡替代原有檢測器中的濾波器,通過懲罰函數對約束恒模代價函數進行求解,獲得前饋神經網絡權值和參數的迭代公式,

2009-04-22 08:41:47 29

29 RBF 徑向基神經網絡在工程中,尤其是各種智能控制中的應用十分廣泛。其隱含層的非線性激活函數經常采用高斯徑向基函數,這一函數為一指數函數。指數函數用硬件實現起來比

2009-09-02 18:06:46 24

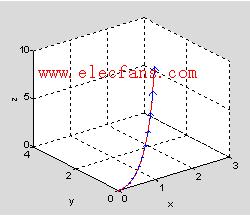

24 函數的可視化與Matlab作2.1 實驗與觀察:函數的可視化2.1.1 Matlab二維繪圖命令1.周期函數與線性p-周期函數 ◆

2008-10-17 00:30:30 1992

1992

Fjodor Van Veen 寫了一篇名為《The Neural Network Zoo》的文章(詳見圖文并茂的神經網絡架構大盤點:從基本原理到衍生關系 ),全面盤點了神經網絡的大量框架,并繪制

2018-07-03 09:46:00 2492

2492

為了克服現有語音可視化方法的局限性,該文提出了一種基于神經網絡的漢語聲韻母可視化方法,通過集成不同的語音特征進入一幅圖像中為聾啞人創造了語音信號的可讀模式。采用小波神經網絡來進行位置信息映射和顏色

2017-10-31 09:56:55 12

12 希望你理解了激活函數背后的思想,為什么要使用激活函數,以及如何選用激活函數。

2018-01-10 11:53:11 6018

6018

我們將純粹用SQL實現含有一個隱藏層(以及帶 ReLU 和 softmax 激活函數)的神經網絡。這些神經網絡訓練的步驟包含前向傳播和反向傳播,將在 BigQuery 的單個SQL查詢語句中實現

2018-05-15 17:48:00 978

978

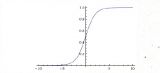

ReLU(Rectified Linear Unit,修正線性單元)訓練速度比tanh快6倍。當輸入值小于零時,輸出值為零。當輸入值大于等于零時,輸出值等于輸入值。當輸入值為正數時,導數為1,因此不會出現sigmoid函數反向傳播時的擠壓效應。

2018-05-16 11:18:08 31420

31420

超參數是必須初始化到網絡的值,這些值是神經網絡在訓練時無法學習到的。例如:在卷積神經網絡中,一些超參數是內核大小、神經網絡中的層數、激活函數、丟失函數、使用的優化器(梯度下降、RMSprop)、批處理大小、要訓練的周期數等。

2018-06-11 11:47:02 2891

2891

非線性:當激活函數是線性的時候,一個兩層的神經網絡就可以基本逼近所有的函數,但是,如果激活函數是恒等激活函數的時候,就不滿足這個性質了,而且如果MLP使用的是恒等激活函數,那么其實整個網絡跟單層神經網絡是等價的

2018-08-02 14:52:48 11034

11034

的 Logistic regression 就可以認為是一個不含隱含層的輸出層激活函數用 sigmoid(logistic) 的神經網絡,顯然 Logistic regression 就不是 deep 的。不過,現在

2018-09-06 20:48:01 557

557 怎樣理解非線性變換和多層網絡后的線性可分,神經網絡的學習就是學習如何利用矩陣的線性變換加激活函數的非線性變換。

2018-10-23 14:44:21 3741

3741 今天要為大家推薦一套超酷炫的,用于構建神經網絡3D可視化應用的框架——TensorSpace。TensorSpace 可以使您更直觀地觀察神經網絡模型,并了解該模型是如何通過中間層tensor的運算來得出最終結果的。

2018-11-16 08:43:02 3832

3832 降低了網絡需要訓練的數量級。本文以MINST手寫體數據庫為訓練樣本,討論卷積神經網絡的權值反向傳播機制和MATLAB的實現方法;對激活函數tanh和relu梯度消失問題進行分析和優化,對改進后的激活函數進行訓練,得出最優的修正參數

2018-12-06 15:29:48 14

14 神經網絡到底是如何運作的?

2019-03-11 09:34:37 3660

3660 如果說節點是神經網絡的核心,那么激活函數和感知器就是神經網絡核心的核心,幾乎在所有的神經網絡中都可以看到他倆,這一小節我就來講解一下激活函數和感知器。

2020-03-20 19:21:43 1126

1126 OpenAI今天發布了Microscope,這是一個神經元可視化庫,從九個流行的或大量的神經網絡開始。總而言之,該集合包含數百萬張圖像。

2020-04-15 21:10:14 2790

2790 什么是神經網絡激活函數?激活函數有助于決定我們是否需要激活神經元。如果我們需要發射一個神經元那么信號的強度是多少。激活函數是神經元通過神經網絡處理和傳遞信息的機制

2020-07-05 11:21:21 3352

3352

責任編輯:xj 原文標題:盤點 23 款神經網絡的設計和可視化工具 文章出處:【微信公眾號:中科院長春光機所】歡迎添加關注!文章轉載請注明出處。

2020-10-12 14:04:38 1970

1970

導讀 對神經網絡進行可視化分析不管是在學習上還是實際應用上都有很重要的意義,基于此,本文介紹了3種CNN的可視化方法:可視化中間特征圖,可視化卷積核,可視化圖像中類激活的熱力圖。每種方法均附有相關

2020-12-29 11:49:59 2095

2095 激活函數(Activation Function)是一種添加到人工神經網絡中的函數,旨在幫助網絡學習數據中的復雜模式。類似于人類大腦中基于神經元的模型,激活函數最終決定了要發射給下一個神經元的內容。

2021-03-05 16:15:48 12822

12822

通過對傳統BP神經網絡缺點的分析,從參數選取、BP算法、激活函數、網絡結構4個方面綜述了其改進方法。介紹了各種方法的原理、應用背景及其在BP神經網絡中的應用,同時分析了各種方法的優缺點。指出不斷提高網絡的訓練速度、收斂性和泛化能力仍是今后的研究方向,并展望了BP神經網絡的研究重點。

2021-06-01 11:28:43 5

5 minibatch 的大小, 輸出神經元的編碼方式, 代價函數的選擇, 權重初始化的方法, 神經元激活函數的種類, 參加訓練模型數據的規模 這些都是可以影響神經網絡學習速度和最后分類結果,其中神經網絡的學習速度主要根據訓練集上代價函數下降的快慢有關,而最后的分類的結果主要

2021-06-19 14:49:14 3122

3122

PyTorch已為我們實現了大多數常用的非線性激活函數,我們可以像使用任何其他的層那樣使用它們。讓我們快速看一個在PyTorch中使用ReLU激活函數的例子:

2022-07-06 15:27:37 2146

2146 作者:Mouaad B. 來源:DeepHub IMBA 如果你剛剛開始學習神經網絡,激活函數的原理一開始可能很難理解。但是如果你想開發強大的神經網絡,理解它們是很重要的。 但在我們深入研究激活函數

2023-04-18 11:20:04 322

322

作者:MouaadB.來源:DeepHubIMBA如果你剛剛開始學習神經網絡,激活函數的原理一開始可能很難理解。但是如果你想開發強大的神經網絡,理解它們是很重要的。但在我們深入研究激活函數之前

2023-04-21 09:28:42 382

382

? 只要你用了ReLU,我們就是好朋就是“淺度學習”。 最近有研究證明,所有基于ReLU的深度神經網絡都可以重寫為功能相同的3層神經網絡。 ? 基于這個證明,倫敦國王學院的研究團隊還提出一種為任意

2023-07-03 14:13:34 314

314

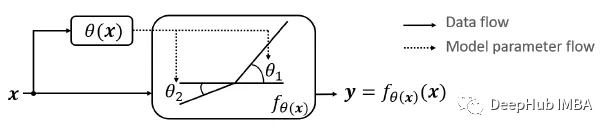

這是我最近才看到的一篇論文,它提出了動態ReLU (Dynamic ReLU, DY-ReLU),可以將全局上下文編碼為超函數,并相應地調整分段線性激活函數。

2023-09-01 17:28:18 412

412

電子發燒友App

電子發燒友App

硬聲App

硬聲App

3187

3187 441

441

18

18 29

29 24

24 1992

1992

2492

2492

12

12 978

978

31420

31420

2891

2891

11034

11034

557

557 3832

3832 14

14 1126

1126 2790

2790 3352

3352

1970

1970

2095

2095 12822

12822

5

5 3122

3122

2146

2146 322

322

382

382

314

314

412

412

評論